İndekslemede 130 Gün Kuralı

Yapay zekanın yükselmesiyle birlikte, webdeki içeriklerin çoğalmasına bağlı olarak tarama problemleri de baş göstermeye başladı. 2020 yılında, Pandu Nayak tarafından açıklanan bilgilere göre, Google’ın 400 milyardan fazla web sayfasının arşivde barındırıldığını biliyoruz.

Bu sayı artmaya devam ettikçe, Google’ın nakit ve vakit olarak sorunlar yaşayacağı tahmin ediliyordu. Bu nedenle, Googlebot tarafından taranan web sayfalarının indekslenme süreleri yavaşladı ve hatta indekslenme oranları düştü.

Alexis Rylko tarafından yapılan analize göre, Google eğer bir web sayfasını son 130 günde hiç ziyaret etmemişse, indeksten siliyor.

Adam Gent tarafından bu çalışmaya dayandırılarak yapılan bir diğer analiz de ilgili veriyi doğruluyor.

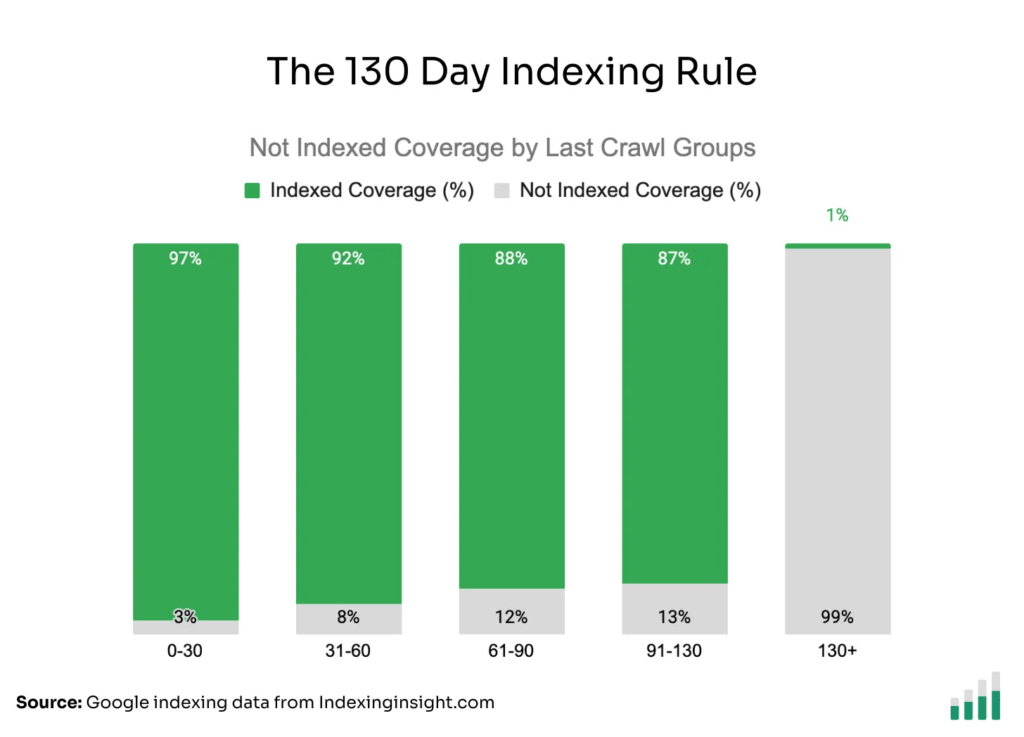

Yapılan analizler neticesinde elde edilen veriler şu şekilde:

- Son 0-30 gün aralığında taranan web sayfaları %97 olarak indeksli,

- Son 31-60 gün aralığında taranan web sayfaları %92 olarak indeksli,

- Son 61-90 gün aralığında taranan web sayfaları %88 olarak indeksli,

- Son 91-130 gün aralığında taranan web sayfaları %87 olarak indeksli,

- Son 130 gün içinde taranmayan web sayfaları ise %1 ihtimalle indeksli durumdadır.

En son tarama tarihini nasıl tespit edebiliriz?

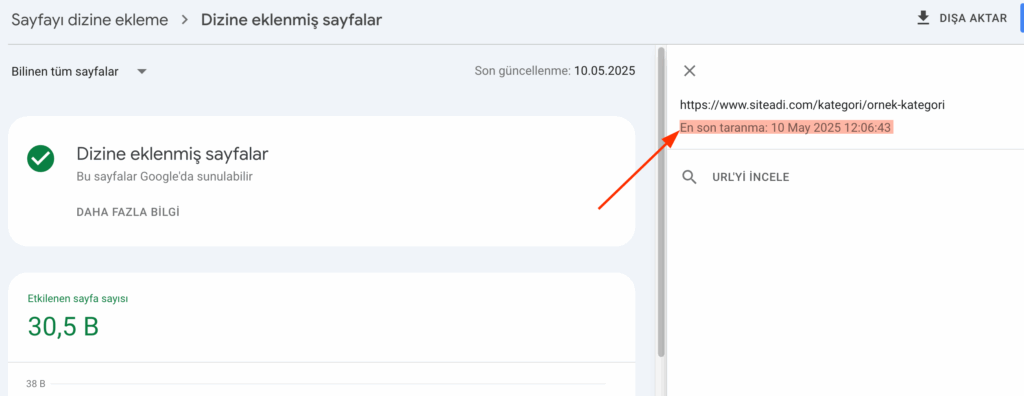

Son tarama tarihini, dizine ekleme raporu içerisinden sayfa özelinde bulabilirsiniz.

Ayrıca, eğer sunucunuz log verilerini tutuyorsa, Screaming Frog Log File Analyzer ile de tüm tarama verilerini segmentlere ayırarak inceleyebilirsiniz.

Peki, Google neden bir web sayfasını taramaz?

İlk akla gelen, web sayfasının tarama derinliğinin fazla olması. Eğer bir web sayfası, anasayfadan itibaren maksimum 3 klikte erişilebilir olmalıdır. Eğer derinlik çok fazlaysa, tarama sıklığı da düşecektir.

İkinci olarak, eğer web sitesinde aynı “arama niyetine yönelik” farklı bir web sayfası varsa, Google bu sayfaların ziyaret sayılarını da düşürüyor. Bu nedenle, cannibilazation (yamyamlık) konularına da ekstra dikkat etmek gerekiyor.